「智能运维大数据平台」智能运维大数据平台的演讲共享资源实录。伴随着着各种各样创新科技的出现,“人工智能技术技术性”一词越来越多地出现在大伙儿的饮食起居中,而运维服务朋友总听与自身工作上息息相关的便是智能运维了。但在现如今,我国绝大部分的智能运维并没有完全立式,所有行业处在一个早期的探索阶段。因此,很多运维服务人或多或少全是有那般的疑虑:一个传统企业的智能运维之途该如何走?AIOps的架构设计与组成究竟从哪里立式?今天,我也为大家对于智能运维大数据平台的演讲共享资源实录。

这篇共享资源,重要从运维服务规定的根本原因考虑到,慢慢测算出AIOps的架构设计与组成,在预估整个过程中,饶琛琳详细说明了时钟频率预测分析剖析、异常检测、方法简述的分析基本概念与进行方式 的具体场景,以及相符合的对外开放源码新项目选择。实录详细资料下列,你仍在等哪些,赶快来收取干货知识专业知识吧!

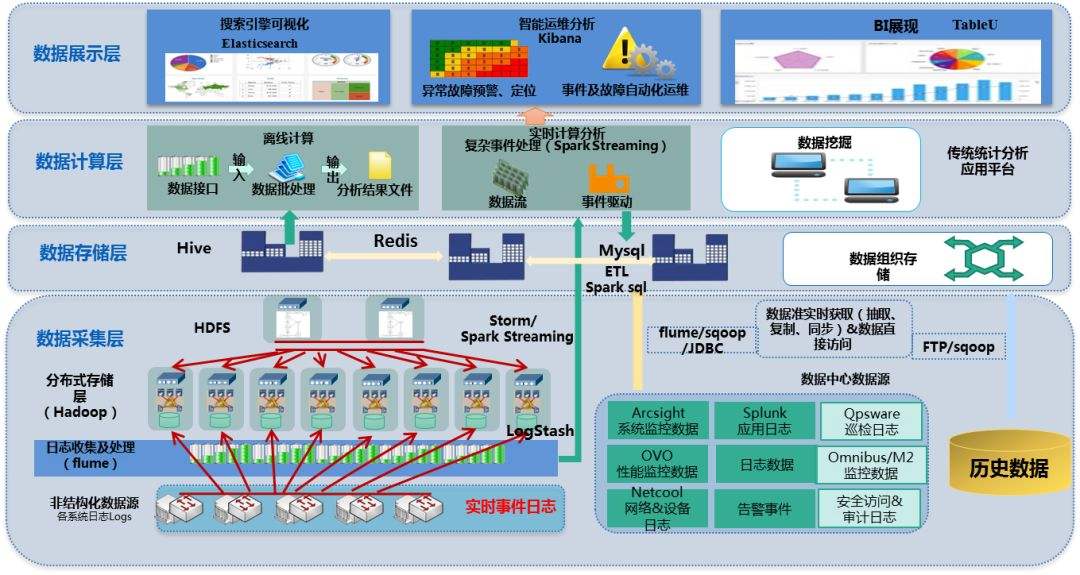

「智能运维大数据平台」智能运维大数据平台的演讲共享资源实录。今天共享资源的是数据驱动的智能运维综合服务平台,可以 看到,题型有两个点,第一个是综合服务平台,第二个是数据驱动。主要是共享平台服务平台本身的构件架构,重要放进一些与数据信息数据分析相关的关键环节,包括对异常检测、时钟频率预测分析剖析、模块聚类算法等场景的剖析。

与传统运维服务比照,智能运维可以 更灵活、更好用,并且快速探索数据信息。比如有1000台网站服务器,如果没有一个统一的综合服务平台,要发现问题会十分麻烦。

探索和实验综合服务平台意味着啥意思呢?这事实上是总结了运维服务工作员的一个运作情况:猜测、尝试错误,倘若尝试错误不对,再进行下一次尝试错误,即一个探索发现的整个过程。倘若这一整个过程推行不够快,就意味着着解决常见问题的速度会越来越慢一点。因此,我认为,这一速率难点对于运维服务来讲十分重要的一个点。

「智能运维大数据平台」智能运维大数据平台的演讲共享资源实录。从详细情况来看,AIOps平台里理应有哪些物件?我觉得下面的描述很趣味性,数据湖,即存储采集数据,也是有自动化控制、记录系统、互动交流系统、管控生态圈。

将这好几个系统拆分一下,我们可以发现,视频监控系统系统软件和互动交流系统在运维服务的分类中比较弄混。一般来说,视频监控系统系统软件担负的只是把数据信息抓下来,接着去辨别是不是不大好,但是实际上视频监控系统系统软件还要担负一个重要的流程,也就是这个难点和其他难点有没有联系?理应把这个问题发给谁?消息推送时仅有告之有那麼一个难点,还是描述别的信息内容?这一段流程要比数据采集一部分更重要。要做好支点运维服务目的的综合服务平台,就务必将其单独拆分充分考虑。

这张幻灯片图片看起来好像和AI没有非常大的关系,如果具备这类系统,就可以认同这是一个Ops平台了,但是在这个综合服务平台中,AI是什么

相近这种的深度神经网络Web服务服务平台,现阶段目前市面上理应有三四十种,但这种综合服务平台对运维服务来讲并没有实际的现实意义。

大伙儿运维服务人真正务必的是深度神经网络在运维服务工作方面的运用。AppDynamics的2016年度总结中明确指出一些对于APM制造商来讲可以 做出的AI场景,可以 对这类内容进行拆装,获得运维服务人的真正规定。

我这里提供一种很好的拆装方式 ,对于运维服务工作员来讲,最重要的還是要去解决底层规定,包括管控、事件答复、根因分析、CICD、容量总体规划、部署,将这幅图与图中AI主要用途进行比照,便会得到从专业性到规定应用正中间的关系。

从相符合的关系中可以 看得出来,很多传动系统传动链条是相通的,而最终的目的都是要做好一个管控,即最底层的规定。此外,也是有一条链是“根因分析-智能报警-自动化控制”。也就是上面的传动系统传动链条发现常见问题,最后一条链发出声音,并建立过后流程。

广泛性主要用途

时钟频率预测分析剖析

下面重要聊一下两个大传动系统传动链条里好几个最广泛、比较好着手的场景。第一个是时钟频率预测分析剖析,预测分析剖析这一话题讨论探讨十分大。在与消费者交流与沟通时,也会被问及一些可怕的预测分析剖析规定,但真正可立式的规定,还是这种数据量充裕大、细,且多方位,此外预测分析剖析的是比较细致情况的规定。

就算是靠谱的未来预测分析剖析规定,也依然是非常大的话题讨论探讨。例如下边的图,有着时序数据,以白框为点,中间的绿线是数据信息详细情况,剩下三条线是用了三种不一样的预测算法得到的预测分析剖析结果,你可以发现依然各不相同。

因此,即使有数据信息,在要求不太高的情况下,可否做依然是一个务必划分的难点。

回到运维服务领域,大家比较广泛到的编码序列,对于四种广泛的编码序列情况我们可以想到它理应怎样走,此刻就可以想办法让机器设备去想。可以用应用统计学上的方式 去做时钟频率预测分析剖析,也就是指数光洁,从一阶、二阶、三阶持续测算,α、β、γ会越来越多。

如果有一百万条那般的线,依次去配α、β、γ,那工作量很有可能十分宏大。就那麼好几个基本参数、十几条线,很有可能就必须开销两三个月的时间来做,倘若说所有的管控指标全那麼做,那不容置疑并不是具体的。

在这个基本上,就可以充分考虑用一些减轻人工作量的方式 ,大伙儿可以用各式各样不一样应用统计学里的涵数确立情况,最后得到一个相对最好的MSE,确立最好是基本参数,那般工作量便会减轻一些。

对于时钟频率预测分析剖析的开源网站选择有很多,除了不久提及的RRDtool、Holt-Winters外,也是有Facebook、hawkular的对外开放源码新项目。

前面讲的对自动化控制调参的整个过程,很多具体的关键环节来自Redhat最新项目,虽然主最新项目早就没有升級,但是这一子项目还是极力推荐大家看一下。

异常检测

第二个场景是异常检测。事实上预测分析剖析本身就是异常检测的一种方式 ,但异常检测并不只是这类方法。例如下面这二种,虽然是比较可怕的情况,但并不代表着在长时间维度下不易出现,这类情况应用一切光洁的方法 ,对每根线的异常检测都没有一切现实意义。

再以下边这种线,在不一样的阻拦阶段差别十分大,但用均非常值得话,所有这一段中平均值都是一条线上,没法辨别每根线的一切区别。

此外,异常检测还要充分考虑一个最基本的同环比,也要充分考虑同比的扩展性。

这里可以 介绍一下datadog的异常检测,提供4种检测方法 ,Basic采用的是四分位方法 ,Agile用的是SARIMA优化计算方法,Robust用的是发展趋向融解,Adaptive在我看起来,采用的是sigma相对标准偏差。

下面是在不一样场景下,这四种不一样优化计算方法对这一条线是否发现异常的辨别,我们可以看到,倘若无需对本身工作流程的掌握,单纯就是一个优化计算方法,一切都一切正常,如第一个想过对比,但在实际工作方面却不太可能。

因而在大家的确要去做异常检测时,尽量对工作流程要有一定的把握,弄清楚metric每根线背后代表着的寓意,才能够 对各式各样优化计算方法进行选择,这个地方没有wifi锁匙。

对于异常检测的开源网站库选择,一些是分子结构的,一些是构成的。Etsy的skyline是比较高级的场景,里面带有数据信息存储、异常检测分析、警报等;Twitter、Netflix、Numenta是纯粹的深度神经网络优化计算方法库,没有一切附加内容;Yahoo的egads库可以 算为异常检测的分子结构场景,比Twitter和Netflix级别稍高。

方法聚类算法

第三个要讲的是数据信息简述-文本聚类。我们知道,前面讲的两类都是管控metric情况,但是一些常见问题单纯看metric是无法寻找常见问题的。在排障整个过程里能看好多个线,包括时间相关性或者时钟频率聚类算法,还能够做根因分析,但这类还不充裕。

我这边可以 提供的是除此之外一条设计构思,日志易是一款日志分析系统系统软件产品,企业有各种各样的系统,导致各种各样的事件日志,倘若依据ETL的方式 把事件日志收集起来,很有可能要写上万个表达式,是不大可能开展的日常任务。

我们可以看到下边的图有四行事件日志的输出编号,可以 看得出来日志格式和种类是较为比较有限的。假若这四行编号打了1000万条,事实上也就是这四行编号打的而已。倘若从人的掌握上看,这四行编号就讲过2件事:1.有一个User登录了,2.定义了一个变量定义。我们要干的是什么?就是把1000万行编号测算到四个不一样的事件日志样式。

除此之外一个关键环节,在处理自然语言理解了解时,分号还是分号没有一切现实意义,大伙儿关注的是文本,但事件日志里面的每一个标识都很重要,是一个不同寻常的聚类算法聚集方式 。如果我们不肯上深度神经网络专业性,只为本迈出第一步,就可以应用这一特性,除去文本,留出这堆标点符号。

拆换之后,留出的内容也充裕反映出一些信息。例如下面这一实例,这一思科交换机的ASA事件日志情况,进行处理后,得到了一些一模一样的标点符号,大伙儿就可以推论应该是一样的内容,这个是比较简单的方式 ,因为比较粗略,因而推论得也不是十分有效。

可以 再往前一步,再加一点聚类算法的物件,先走TFIDF,获得一些文本的引流矩阵的矩阵的特征值,再走一个DBSCAN,拿每一个聚类算法的样版情况来看。当看到某一样版不太对,就单独把这个模版拿出来,调整基本参数,将聚类算法里的事件日志再度聚类算法,再观察一下情况。

聚类算法的设计构思是相通的,先获得,做聚类算法,聚类算法出来不大好,再切分一个小类。但是实际上线运用的话,还是有很多难点务必充分考虑的。用DBScan聚类算法的运行时间比较长,是一个偏位线运行状况,而且占据的资源也多。

除了这类优化计算方法上的难点,还有一个设计构思上的难点,单纯只是完全的聚类算法,没有办法合适地辨别思维逻辑编号,也就不可以保证掌握它的原始编号是什么的目的。

这里大伙儿参考一下日本电器美国实验室之前公布的一篇论文,他们的优化计算方法叫HLAer,基本概念并不是马上上一大堆文本的聚类算法方式 ,仅仅反过来去测算。

大伙儿做的是运维服务事件日志,绝大多数情况下,运维服务事件日志有很多东西无需耗费CPU处理。第一个,像Num、Date、IP、ID等都是运维服务IT日志里一定会出现的,但在关注方法时不易关注这类。因此,可以 在一开始就把这类信息拆换,节省工作量。

第二个是两端对齐,两端对齐也是耗资源的,如何减少两端对齐的状况下强制性匹配资源呢?可以 一开始先走一个间隔极其小的聚类算法,那般每一类中的原始文本区别十分小。这时候意味着着第二步得到的最底层聚类算法去做两端对齐时,在这个类里的两端对齐耗损便会十分小,可以 马上做方法发现。

到第四步的状况下,虽然还是聚类算法,但是消耗的资源早就非常少,因为得到的数据量早就并不大,可以 快速开展所有速度的迭代更新。

这是一个例子,最开始将二根事件日志去做层级,再去做一个发现,接着去做一个两端对齐和一个方法发现。依据这类方法,可以 把所有事件日志一层一层通常上拽,最终把所有结果全部测算出来。